En mi artículo anterior de esta serie[1], argumenté que los datos, incluso cuando son imprecisos e incompletos, como los que vamos teniendo sobre la marcha de la pandemia de COVID-19, pueden ser suficientemente buenos para ir comprendiendo la realidad e ir tomando decisiones razonablemente adecuadas a las circunstancias. Pero, para que eso suceda, nos tenemos que acercar a los datos con la actitud adecuada, con un espíritu racional y escéptico, que implica aceptar que estos puedan poner en cuestión nuestras ideas preconcebidas. Sin embargo, nuestra inclinación espontánea, según llevan mostrando muchos años los psicólogos, nos conduce a fijarnos en la información que confirma nuestras ideas preconcebidas y a desechar la que la contradice. A ello se le llama sesgo de confirmación; y, para luchar contra él, es necesario un cierto aprendizaje, un entrenamiento en la tarea, antipática, de hacer de abogados del diablo contra nuestras propias ideas.

Precisamente, evitar ese sesgo es una de las virtudes de lo que llamamos el método científico. En su versión más simplificada, consiste en que el investigador formula en primer lugar una hipótesis, que no es más que una sospecha, del tipo: “cuando se da el fenómeno A, se produce el fenómeno B”. La hipótesis puede originarse por una observación previa, espontánea o planificada, o puede originarse en razonamientos teóricos (“lo que sabemos del fenómeno A hace esperar que produzca el fenómeno B”).

El siguiente paso, central, es diseñar un experimento, o una observación sistemática de datos, para verificar en qué medida la hipótesis se reproduce de manera uniforme: si siempre que se da A, encontramos también B; si B solo aparece cuando, además de A, hay otros factores presentes; o si tal vez B aparece más bien cuando están presentes C o D, independientemente de la presencia de A...

El método científico requiere buscar todas las maneras posibles en que nuestra hipótesis puede ser falsa, incompleta o imprecisa

Por decirlo así, el método científico requiere buscar todas las maneras posibles en que nuestra hipótesis puede ser falsa, incompleta o imprecisa. Y solo cuando hemos puesto a prueba de mil maneras las hipótesis, y estas resisten, empezamos a hablar de que tenemos una teoría o una ley, aquella parte de la ciencia que creemos que es “cierta”, siempre de manera provisional y sujeta a rectificaciones futuras si aparecen hechos que las contradicen.

Los científicos aprenden por las malas, a base de muchos experimentos y observaciones “fallidos” –en realidad no, porque aprender que una hipótesis no funciona, o no del todo, es también valioso–, que muy pocas de las hipótesis que se ponen a prueba pasan ese cribado de la experimentación y la observación para ser aceptadas como leyes o teorías. Ese es el camino que nos ayuda a recorrer la ciencia: el camino de los muchos “parece que esto es así” a los pocos “estamos casi seguros de que esto es así”.

Ese camino es el que hay que transitar también en el campo de la medicina cada vez que alguien propone un nuevo tratamiento: nuevos fármacos, nuevas combinaciones de ellos, distintas dosis o aplicaciones de un fármaco conocido a una enfermedad diferente. Los médicos de todo el mundo han interiorizado la regla de que no debes creerte nada a menos que esté confirmado por ensayos clínicos aleatorizados[2], es decir, ensayos en los que los pacientes estudiados son asignados al azar para recibir el tratamiento estudiado, o para recibir un placebo (o, en otros casos, para recibir el tratamiento previamente conocido), a poder ser sin que el paciente ni el administrador del tratamiento sepan si recibe una cosa u otra. Este es el modelo ideal de los ensayos médicos, desarrollado tras constatar múltiples veces en la historia de la medicina que se habían dado por buenos tratamientos erróneos, porque al descubridor o proponente de un medicamento o procedimiento nuevo o modificado le cuesta mucho ver los datos con objetividad, sin caer en los sesgos cognitivos que nos llevan a todos a seleccionar los datos favorables a nuestras ideas preconcebidas, o a desarrollar razonamientos ad hoc para eliminar los datos que no se ajustan a ellas.

Tal vez recuerden ustedes cómo en las primeras semanas de la pandemia circularon por las redes sociales vídeos de médicos que se grababan dando explicaciones a sus colegas sobre pruebas de tratamientos que estaban haciendo a los pacientes con COVID-19, explicando en qué circunstancias funcionaban o en cuáles no. Probablemente, lo que vimos los ciudadanos comunes fue solo una ínfima parte de los muchos mensajes de ese tipo que en aquellos días frenéticos circularían entre el personal sanitario, explicándose unos a otros lo que creían ir aprendiendo, a base de prueba y error. Luego, llegaron las oleadas de noticias sobre estudios preliminares que apuntaban a posibles medicamentos o tratamientos preventivos o curativos para la COVID-19: la vitamina D, el Remdesivir, la Hidroxicloroquina (la favorita de Trump), el Tocilizumab, la Dexametasona y otros corticoides, el plasma convaleciente…

Con el paso del tiempo, muchas de las ideas de los vídeos de urgencia, e incluso de las que aparecían en notas de prensa, apoyadas en estudios preliminares prometedores, van siendo abandonadas. Lo que parecía cierto, al mirarlo con cuidado, creemos que no lo es. Es el método científico en acción, aunque en una variante acelerada y comprimida en el tiempo.

¿Y qué tiene que ver esta disquisición sobre el método científico y los ensayos médicos con la situación del ciudadano, o el periodista, que intenta informarse, o informar a otros, sobre la pandemia? Creo que el paralelismo es apropiado, porque, en cierto modo, cuando tratamos de entender el mundo, todos somos científicos aficionados o aprendices de científicos que nos planteamos preguntas sobre por qué suceden las cosas de una forma u otra y, aunque no las llamamos así, elaboramos hipótesis para responderlas.

En la pandemia no nos han faltado cuestiones sobre las que hacernos preguntas y pensar respuestas tentativas. Con más o menos esfuerzo, interés o desánimo, hemos ido recibiendo una multitud extraordinaria de informaciones sobre cuestiones científicas como las mencionadas y otras muchas. Pero también, y es quizá la parte más relevante como ciudadanos, hemos ido conociendo las medidas introducidas en diferentes lugares para reducir los contagios, con muchas combinaciones diferentes de reglas en relación con las mascarillas; la distancia social; las reuniones de personas en espacios abiertos, domicilios o centros de trabajo; el cierre o las reducciones de horarios o de aforos en locales comerciales, culturales, de hostelería y gimnasios; el cierre de centros educativos de diferentes niveles; las limitaciones a los viajes dentro y fuera de los países, y los procedimientos para buscar, testar y aislar a las personas con síntomas o con contacto estrecho con personas infectadas.

A partir de esas informaciones, hemos tenido que ir elaborando y debatiendo nuestra comprensión de lo que iba pasando. Y así hemos ido construyendo nuestro entendimiento sobre qué funcionaba y qué no, a qué países les estaba yendo mejor o peor y, en definitiva, qué Gobiernos lo estaban haciendo bien o mal (olvidando a menudo la posibilidad de que la evolución de la pandemia en cada país dependiera más de otros factores que de las decisiones gubernamentales).

Para empezar, parece claro que, hasta la fecha, los países de Extremo Oriente, incluida la propia China, han tenido un éxito incontestable a la hora de controlar la pandemia. También Nueva Zelanda y Australia. Pero qué partes de su experiencia podemos aprender los demás, y cuáles no, no es en absoluto obvio, pues también son países heterogéneos entre sí y sus medidas de lucha contra el virus no han sido en absoluto idénticas.

Si miramos a los países más próximos cultural y políticamente (las democracias relativamente prósperas de Europa y América), en diferentes momentos y en diferentes círculos políticos y mediáticos han ido circulando distintas hipótesis sobre las medidas más exitosas para controlar la epidemia, con diferentes países propuestos como modelos. Por ejemplo, al comienzo de la pandemia, Alemania era el gran ejemplo a seguir entre los países grandes de Europa. La mayoría de los textos que la elogiaban ponían el énfasis en su muy eficaz sistema de rastreo y aislamiento de casos, que sería también elemento clave de los éxitos de algunos países asiáticos. También los países del Este de Europa tenían en general unos datos comparativamente positivos, y esto se atribuyó, entre otros factores, a la rapidez de su reacción, al imponer medidas de confinamiento cuando el virus apenas había llegado, cortando su transmisión. Fue especialmente celebrada la celeridad con que en Chequia se hicieron prácticamente universales las mascarillas, hechas en casa muchas veces, y cómo esto había contribuido a impedir la transmisión del virus. Portugal y Grecia también destacaban como países de renta media en Europa, conectados, turísticos, y que, sin embargo, habían detenido la transmisión de manera muy efectiva con restricciones tempranas. Por supuesto, muchos dieron por hecho que los Estados Unidos, con un liderazgo político en el nivel federal que podemos benevolentemente calificar de errático y un sistema sanitario privado con un porcentaje considerable de la población sin seguro médico o con un seguro restringido, tendría resultados mucho peores que los de Europa.

Casi todas las ideas derivadas de esos primeros meses sobre lo que estaba pasando o iba a pasar en diferentes países resistieron mal el paso del tiempo. Los casos ejemplares del Este de Europa, Portugal y Grecia ya no lo fueron tanto. Los datos de Alemania después del verano se parecieron mucho más a los de otros grandes países. Estados Unidos no ha tenido tasas de contagios o fallecimientos claramente diferentes de los de la Unión Europea.

Bastantes comunidades pasaron de la cabeza a la cola de los 'rankings', o viceversa, y muchos de los argumentos iniciales resultaron debilitados

También dentro de España las comparaciones entre comunidades autónomas, con incidencias muy diferentes de la pandemia, generaron muchas

hipótesis sobre los factores causales, a veces relacionados con características de las sociedades (grandes ciudades, transporte público, relaciones con otros países, clima seco o húmedo, población envejecida…), y a veces relacionados con la gestión pública (gasto en sanidad, número de tests, sistemas de rastreo de contactos…). Pero, con el paso de los meses, bastantes comunidades pasaron de la cabeza a la cola de los rankings, o viceversa, y muchos de los argumentos iniciales resultaron debilitados.

No obstante, en una situación como la actual, en la que las informaciones son, por necesidad, variadas, cambiantes, incompletas y complejas, es raro que los datos confirmen o refuten de manera categórica nuestras ideas previas. Hay muchas formas de medir la gravedad de la pandemia (casos, hospitalizados, ingresados en UCI, fallecidos, exceso de mortalidad), hay diversas fuentes de información sobre cada una de esas cosas, hay diferentes marcos temporales que se pueden utilizar para hacer las comparaciones y hay también muchas dificultades para medir en una escala comparable las múltiples restricciones al comportamiento de los ciudadanos que los Gobiernos han promovido y su grado de cumplimiento.

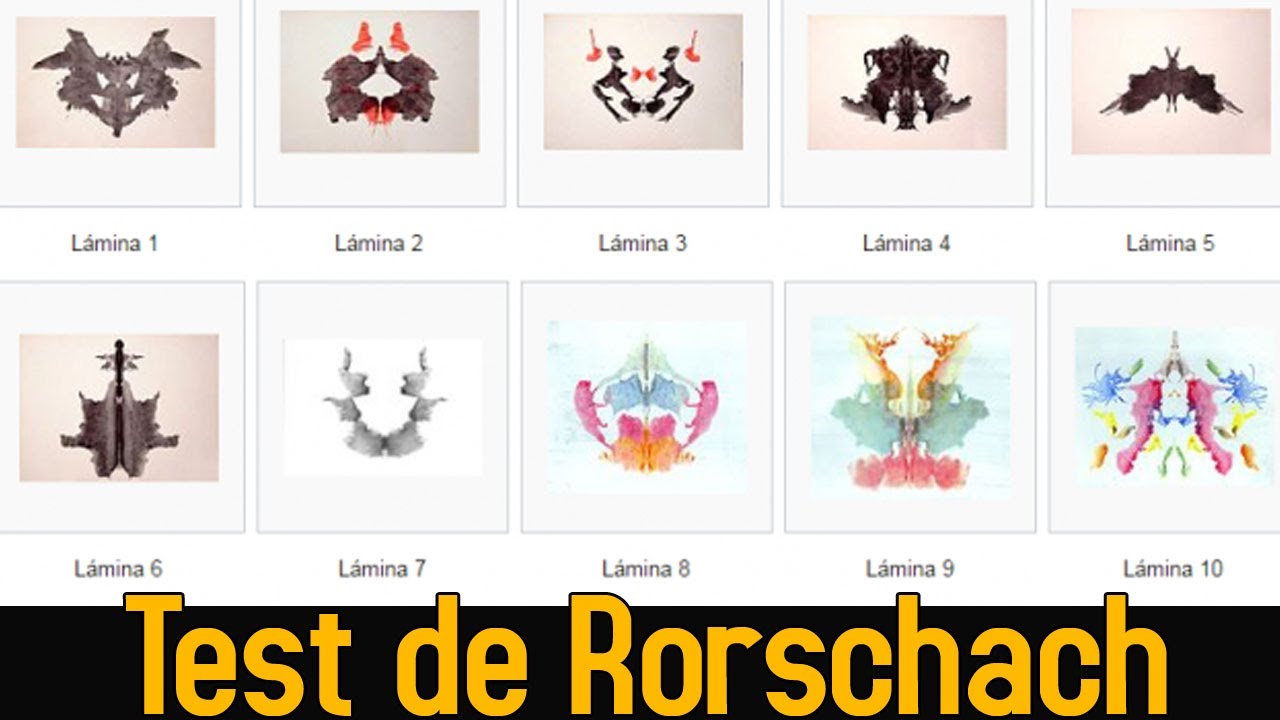

Eso permite que sea posible encontrar “alguna” evidencia favorable a casi cualquier hipótesis y que quien quiera aferrarse a un argumento pueda encontrar asideros en la realidad que le den un aspecto creíble. Los datos de la pandemia, por países y por comunidades autónomas, pueden actuar como un test de Rorschach, en el que cada uno puede ver lo que sus manías, sus sesgos profesionales o sus filias y fobias políticas le llevan a ver.

El símil con el método científico es útil para recordar que la elaboración de hipótesis no es el final, sino el principio, del proceso de aprendizaje

Por ello, la comparación con el método científico es útil para recordar una idea esencial: la elaboración de hipótesis no es el final, sino el principio, del proceso de aprendizaje. Vistos unos datos, y observados ciertos patrones, podemos enunciar una sospecha: tal vez cuando pasa A, pasa luego B. Pero el aprendizaje debe continuar sometiendo nuestra hipótesis inicial a todas las pruebas imaginables para cerciorarnos de que lo que hemos observado en un examen parcial, casual, no sistemático, se mantiene cuando hacemos un examen más amplio.

Dicho de otra forma, el debate público debería emular al proceso científico, en el sentido de favorecer la discusión de todo tipo de propuestas, si bien sometiéndolas a un examen cuidadoso y honesto, en el que se manejara toda la evidencia disponible y en el que los participantes fueran capaces de revisar sus ideas iniciales cuando una nueva evidencia o un examen más meticuloso mostraran que sus argumentos eran incompletos.

Como dije al principio, ese modo de razonar no es espontáneo, sino que hay que aprenderlo. Y puede ser doloroso practicarlo, especialmente cuando nos damos cuenta de que las evidencias no apoyan nuestras ideas preconcebidas sobre la sociedad, la economía o la política o nuestros intereses profesionales o territoriales. Pero es una habilidad que todos los que queremos contribuir a la discusión pública tendríamos que desarrollar, para evitar ver, tal vez, precisos dibujos donde solo hay manchas.

1.- “Borrosos, pero valiosos: una defensa de los ‘malos’ datos”, 'Cuadernos de Periodistas', núm. 40.

2.- Sin embargo, no debe confundirse “no hay pruebas de que eso funcione” con “hay pruebas de que eso no funciona”. Una confusión de ese tipo parece que se produjo al principio de la pandemia sobre las mascarillas.